VR 音频混音入门:什么是空间音频、3D 音频和全景声?

作者:Glenn Forsythe

编译:Hotwill

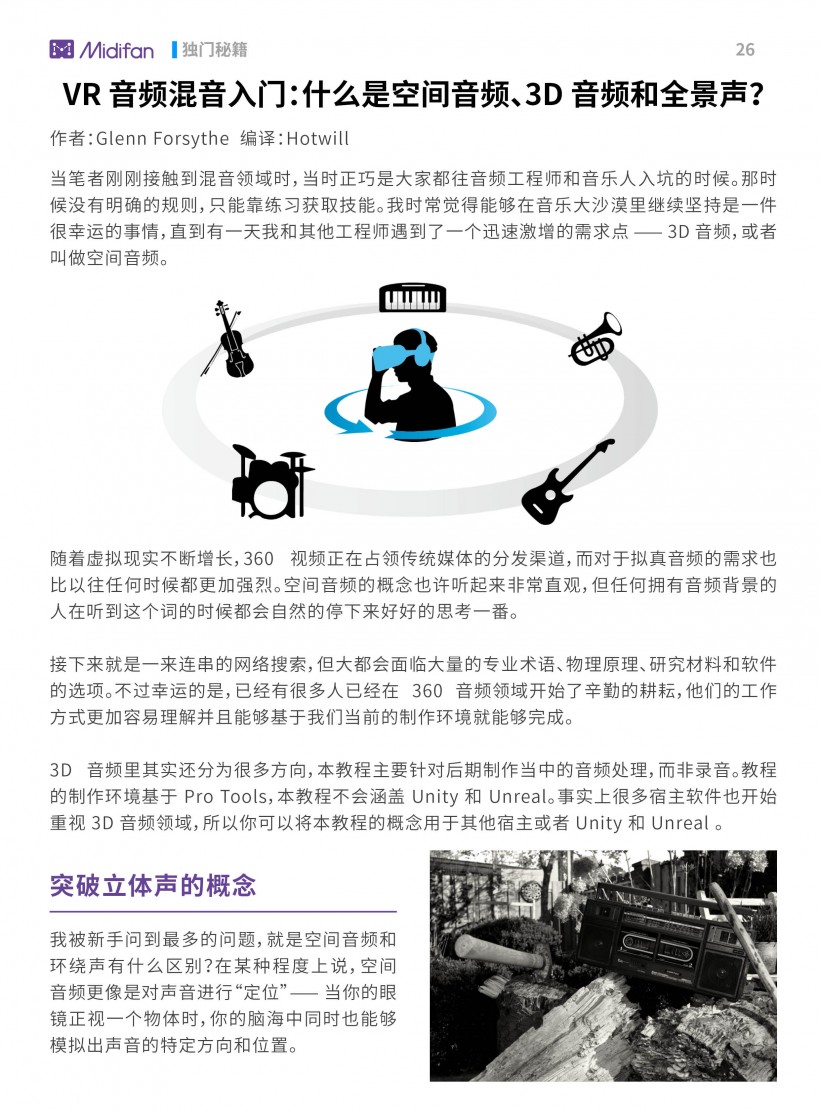

当笔者刚刚接触到混音领域时,当时正巧是大家都往音频工程师和音乐人入坑的时候。那时候没有明确的规则,只能靠练习获取技能。我时常觉得能够在音乐大沙漠里继续坚持是一件很幸运的事情,直到有一天我和其他工程师遇到了一个迅速激增的需求点 —— 3D 音频,或者叫做空间音频。

随着虚拟现实不断增长,360 视频正在占领传统媒体的分发渠道,而对于拟真音频的需求也比以往任何时候都更加强烈。空间音频的概念也许听起来非常直观,但任何拥有音频背景的人在听到这个词的时候都会自然的停下来好好的思考一番。

接下来就是一来连串的网络搜索,但大都会面临大量的专业术语、物理原理、研究材料和软件的选项。不过幸运的是,已经有很多人已经在 360 音频领域开始了辛勤的耕耘,他们的工作方式更加容易理解并且能够基于我们当前的制作环境就能够完成。

3D 音频里其实还分为很多方向,本教程主要针对后期制作当中的音频处理,而非录音。教程的制作环境基于 Pro Tools,本教程不会涵盖 Unity 和 Unreal。事实上很多宿主软件也开始重视 3D 音频领域,所以你可以将本教程的概念用于其他宿主或者 Unity 和 Unreal 。

突破立体声的概念

我被新手问到最多的问题,就是空间音频和环绕声有什么区别?在某种程度上说,空间音频更像是对声音进行“定位”—— 当你的眼镜正视一个物体时,你的脑海中同时也能够模拟出声音的特定方向和位置。

近几年来,混音工程师试图用传统立体声和环绕声的技术来达到空间音频的深度。基本上来说,这可以通过通道振幅声像来实现。在 5.1 环绕声系统中,听者可以对前方和近场水平方向的声音进行定位。虽然这提供了比立体声更多的信息量,但这并没有提供重要的声音垂直高度信息,同时听者也会有很多不可控的局限性。

首先并不是所有人都会有环绕声的行头,就算是立体声配置也是很难得的,也许很多人甚至连“甜蜜点”的体验都没有过。大声场编排的概念也许会解决这些问题,到最后 VR 用户也不需要这些复杂的前期准备了。

现在已经有一些技术针对媒体音箱进行 3D 音频的应用,甚至蓝牙立体声音箱就能够实现。虽然这项技术更多是应用在家庭影院而非 VR 用途,不过接下来一定会有更激动人心的技术出现。

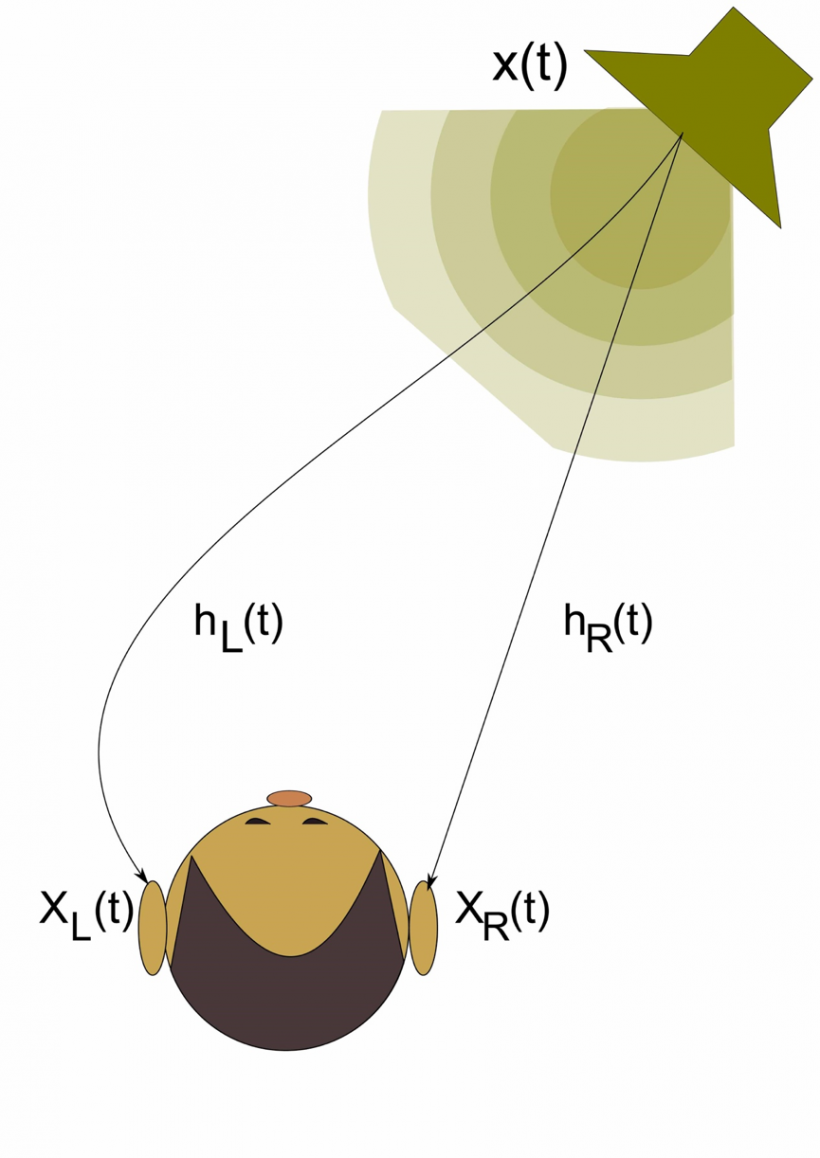

在现实世界中,我们通过两只耳朵来获取声音,也就是传说中的双声道。3D 音频的真实意义就是引导我们的双耳通过一个单一的双声道声源(或者可以说是耳机)来接收声音的定位信息,包括所有的方向和距离。

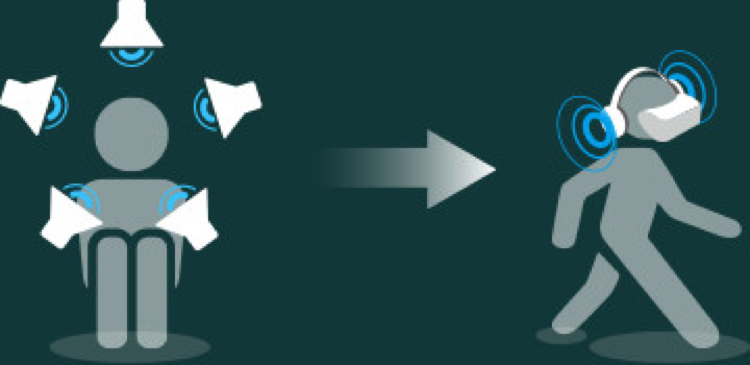

对于 VR 来说,当验收最后成品时,空间音频必须是要能够互动的 —— 声源的位置随着用户的动作产生变化。这是通过渲染引擎实现,它在将声源信息通过双声道的形式传递给耳机的同时,也在收集用户的位置信息。

耳机不仅更适合用于 VR 应用场景,同时对于那些想要提升听觉体验的用户也拥有巨大的优势 —— 很多人手上都有一副耳机,无需再专门投入专用的设备。

通过一个复杂的“头部相关传输函数”算法,即 HRTF,就可以通过立体声源模拟出人耳接收声音时的心理声学现象。HRTF 包含了物体形状、人耳及头部的尺寸、声音到达人耳的不同时间,还有人的耳廓、耳道、人的头盖骨、肩部等对声波的折射、绕射和衍射。在现实世界中,我们就是这样对声音进行定位的。

目标声源(Object)在声像当中的移动

如果说出了电脑和宿主软件意外,我们需要的东西就是一副耳机,那么我们要如何在音乐制作环境下创造出这种神似感官的超酷体验?我们假设有个客户提供了一个 360 相机拍摄的影像,他们需要你将声音“空间化”。我们再假设你会得到录音师的所有声音素材,包括通过领夹式麦克风和 Ambisonic 全景麦克风录制的素材。

即使你没有听过全景声,很快你也会在现实中接触到它。Ambisonic 全景声可以追溯到 70 年代,这是一种多通道的空间音频格式,可以说是专门用来模拟原始三维声场效果的声音系统。它与普通环绕声最大的区别在于,除了水平环绕声,Ambisonic 还增加了“高度”信息,也就是拾音位置或者听众上下的声源。理解 Ambisonic 最直观的方式就是了解心形麦克列阵的原理 —— 全景声麦克风与立体声麦克风技术有很多相似之处,只不过全景声麦克风把双面振膜列阵变成了四面体的心形阵列形式,增加了另外的高度和深度通道。

既然我们都有了如此牛逼的 3D 全景声录音技术,为什么我们还需要领夹式麦克风呢?出了一般混音工程的考量,将近场麦克风声源与远距离的麦克风声源相结合能够创造出更丰富的频率内容。

就声音空间化来说,全景麦克风已经可以做到很多事情,但要创造细致的空间信息还是不够的。想象一下如果你把一个声源放置在靠近麦克风的位置,比如麦克风的盲点,就会产生很大的频率反馈变化,导致声像不明确。而在现实世界中,物体的移动并不会人耳产生频率变化。这明显会影响到我们接受声音位置的准确性,尤其是麦克风接受的信号增多,或是突然有其他声源的加入。

任何直接信号和单声道录音都可以在 360 视频和沉浸式媒体当中代表一个虚拟组件,它们可以按照屏幕中影像的位置进行放置。这些声音并不一定要真实录制,可以来自音色库或者是你为影视内容专门设计的声音素材。

基于 Object 的声像处理基于空间音频的声像处理之上,只不过 Object 是在空间范围内进行移动的,实际上它是通过声源在双声道中进行实时渲染来实现,同时不会对音质造成任何影响。

可下载 Midifan for iOS 应用在手机或平板上阅读(直接在App Store里搜索Midifan即可找到,或扫描下面的二维码直接下载),在 iPad 或 iPhone 上下载并阅读。

文章出处 https://magazine.midifan.com/detail.php?month=2018-06#26

转载新闻请注明出自 Midifan.com

-

2019-12-27 21:00

匿名

能接触到3D混音的国人少之又少,国产VR游戏不是坐不起3D,而是立体声页游手游更赚钱吧。 噢不,他们真的会为音效花钱吗?? 说白了还是好好学立体声靠谱。

匿名

能接触到3D混音的国人少之又少,国产VR游戏不是坐不起3D,而是立体声页游手游更赚钱吧。 噢不,他们真的会为音效花钱吗?? 说白了还是好好学立体声靠谱。